Az AI forradalom energetikai kihívásai

- Károly Attila

- 2025. dec. 7.

- 4 perc olvasás

A generatív mesterséges intelligencia egyre mélyebben szövi át a gazdaságot, szinte minden szektorban hatalmas fejlődést, növekvő produktivitást várnak tőle. Ennek azonban ára van, és itt most nem a munkaerőpiac átrendeződésére vagy az emberi munka kiváltásán van a hangsúly, hanem az ilyen típusú rendszerek - már most is hatalmas - de egyre növekvő energiaigényére. Ez mostanra egy igen jelentős makrogazdasági és klímapolitikai kihívás.

A kérdés már inkább az, hogy tudjuk-e kezelni anélkül, hogy feláldoznánk a klímacéljainkat és részben a gazdasági stabilitásunkat.

Az energiaigény számokban

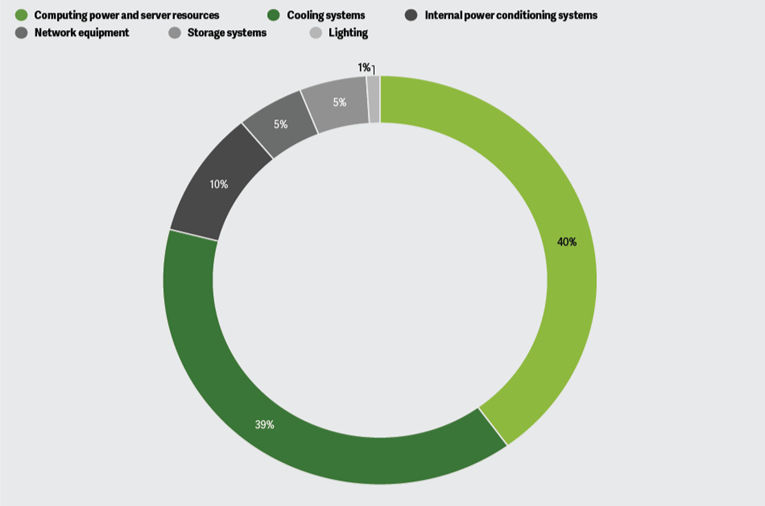

Hogy megértsük a probléma léptékét, érdemes megnézni néhány adatot. 2024-ben a világ adatközpontjai a globális áramfogyasztás „mindössze” 1,5 százalékáért feleltek. Azonban a visszafogottabb becslések szerint is az AI szerverek fogyasztása évente 30 százalékkal nőhet. Egyetlen ChatGPT vagy bármilyen generatív AI alapú lekérdezés ötször annyi áramot fogyaszt, mint egy hagyományos Google-keresés. Ráadásul az OpenAI nem titkolt célja, hogy átvegye a Google vezető szerepét az internetes keresésben, vagyis az ő modelljük legyen az információ elsődleges forrása. Ehhez saját böngészőt is fejlesztenek.

A növekedés már rövid távon is sokkoló mértékű lehet. Kezdve az egyetemes fogyasztókkal, ugyanis egy tipikusan AI-ra fókuszáló hiperskálázott adatközpont már most önmagában annyi áramot fogyaszt, mint 100 ezer háztartás összesítve. De nemzeti szinten is igen jelentős: A Nemzetközi Energiaügynökség (IEA) becslése szerint 2030-ra az adatközpontok energiafelhasználása megduplázódhat, ez számszerűsítve nagyjából 900 TWh (akkora, mint Japán jelenlegi éves fogyasztása).

Mivel a legtöbb adatközpont az Egyesült Államokban található, itt a helyzet még súlyosabb: már most a teljes fogyasztás 4 százalékáért felelős. A Morgan Stanley elemzése arra figyelmeztet, hogy az érintett területeken akár 20 százalékos áramhiány is kialakulhat a megnövekedett felhasználás miatt.

Lokális problémák

A globális adatoknál is ijesztőbbek a lokális hatások, mivel az AI infrastruktúra nem egyenletesen oszlik el, hanem ún. klaszterekbe tömörül, így bizonyos régiók hálózatára extrém terhelést ró, míg máshol egyáltalán nincs hatása. Az amerikai tech óriások a kapacitásuk határait feszegetik.

Az OpenAI, Nvidia-val közös új adatközpontot tervez létesíteni, ehhez 10 gigawattos energiaigénnyel számol. Ez annyi, mint New York nyári csúcsfogyasztása vagy Texas állam felhasználásának 20 százaléka. Azt is érdemes megemlíteni, hogy ezek a központok rengeteg vizet igényelnek a hűtéshez, de mégis gyakran vízhiányos területekre épülnek, mint például Arizona vagy Nevada, tovább súlyosbítva a problémát.

Még extrémebb példa Írország, amely az európai tech hub szerepét tölti be. Az országban annyi adatközpont van jelen, hogy az energiafogyasztás 21 százalékáért felelnek, ami közvetlen kockázatot jelent az ellátásbiztonságra.

Az energia és az adatgazdaság paradoxona

Itt érkezünk el a következő makrogazdasági dilemmához. Az AI kétségtelenül a GDP növekedés motorja lehet a közeljövőben. A Goldman Sachs becslése szerint az elkövetkező 10 évben 7 százalékkal növelheti a globális GDP-t. A McKinsey pedig évi 2,6-4,4 billió dolláros évenkénti növekedést jósol a szektornak. Azonban mindezek alapja az olcsó és bőséges energia.

Az OpenAI hivatalosan így fogalmazott:

"Az elektromos áram stratégiai eszköz – ez támasztja alá az USA AI-előnyét, és ezen keresztül a gazdasági versenyképességünket, technológiai vezető szerepünket és nemzetbiztonságunkat."

Tehát a paradoxon lényege, hogy a növekedés ára a drámaian növekvő fogyasztás. Azok az országok, melyek nem rendelkeznek elegendő saját, olcsó energiatermelő kapacitással, kénytelenek lehetnek növelni az energiaimportjukat, ha tartani akarják a versenyt. Ennek pedig tudjuk milyen hatása lehet: növekvő importfüggőség és nagyobb sérülékenység a nemzetközi energiaár-ingadozások miatt. Vagyis ebben a versenyben a nagyobb importot igénylő régiók (mint például Európa nagy része) ismét hátrányba kerülhet.

Hogyan befolyásolja az Európai klímacélokat?

Az EU egyszerre akar az „AI kontinense” lenni és közben teljesíteni 2030-as és 2050-es klímacéljait. Vajon menni fog egyszerre a kettő? Egy friss elemzés szerint 2030-ra az EU adatközpontjainak áramigénye elérheti a 287 TWh-t, ami nagyjából Spanyolország fogyasztása. Azonban ha megújuló energiaforrások telepítése nem tart lépést ezzel az igénnyel, márpedig egyelőre nem úgy tűnik, akkor mondani sem kell, hogy a hiányzó energiát fosszilis forrásokból, elsősorban földgázból kell majd pótolni.

Az alapforgatókönyv szerint az AI igények 65 százalékát fedezhetik földgázból, ami 2025 és 2030 között 121 millió tonna CO2 kibocsátást jelentene, de önmagában is 3,5 százalékkal növelné az EU teljes kibocsátását. Tehát már a 2030-ig kitűzött célértékbe se férne bele. Merre tovább?

Innovatív zöld AI megoldások

A helyzet komoly, de nem reménytelen. Az előzőekben felvázolt helyzet csak a korábbi ismereteinkre hagyatkozott, de már léteznek tervek az optimalizálásra. Ezek közül néhány:

Hatékonyabb szoftverek: már tesztelnek olyan új technológiákat, mint például a „model pruning”. Ez lényegében a modellek metszése, a felesleges paraméterek eltávolítása.

A „kvantálás”: kisebb energiaigényű számítási pontosság elve, illetve a

„knowledge destillation”, vagyis a kisebb modellek tanítása nagyobb, energiaigényesebb modellekkel. Utóbbit már a Meta is teszteli, a jövőben 50 százalékos energiamegtakarítást vár tőle.

Fejlettebb hűtési technikák: A hagyományos air cooling helyett a liquid cooling használata, mivel a folyadékhűtésnek sokkal nagyobb a hatásfoka.

Magának az AI-nak az alkalmazása az optimalizálásban: Akár maga a problémát okozó technológia is szolgáltathat megoldást. Az AI-t ma már használják hűtési és terheléselosztási rendszerek valós idejű optimalizálására. A Google például már 40 százalékos megtakarítást ért el bizonyos szervertelepein DeepMind alapú hűtésvezérléssel. Ez a körforgásos megközelítés kulcsfontosságú lehet a jövőben.

Célzott zöldenergia-termelés: A tech óriások már felismerték, hogy nem támaszkodhatnak kizárólag a meglévő hálózatra. Egyre gyakoribbak az ún. grid-flexible projektek, ahol az adatközpontok aktívan igazítják a fogyasztásukat megújuló energiatermelés ingadozásaihoz. Például egy főként napenergiából működtetett központ este csökkenti a kapacitását. Emellett terjednek a közvetlenül vízerőművek mellé telepített (hydro-linked) adatközpontok, valamint a cégek dedikált nap- és szélerőmű beruházási.

Összességében kijelenthetjük, hogy a mesterséges intelligencia legalább annyira szoftveres forradalom, mint infrastrukturális és energetikai, amely újragondolásra készteti a döntéshozókat a gazdaságpolitika és a klímavédelem terén.

Hozzászólások